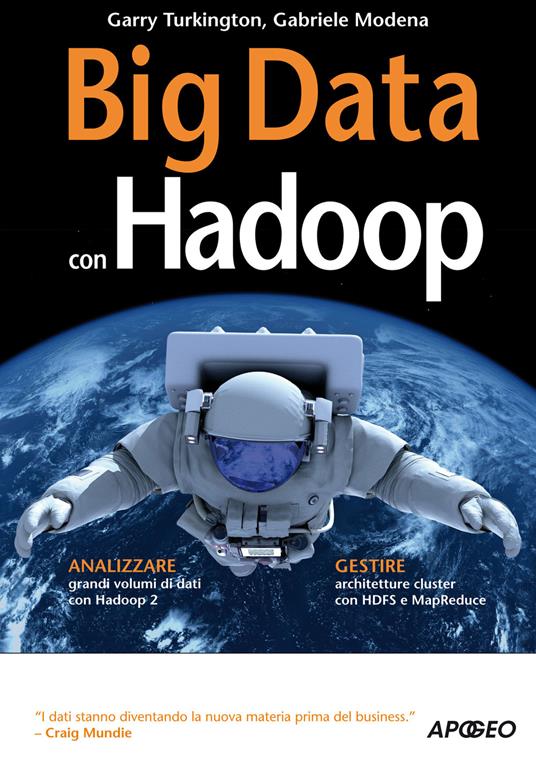

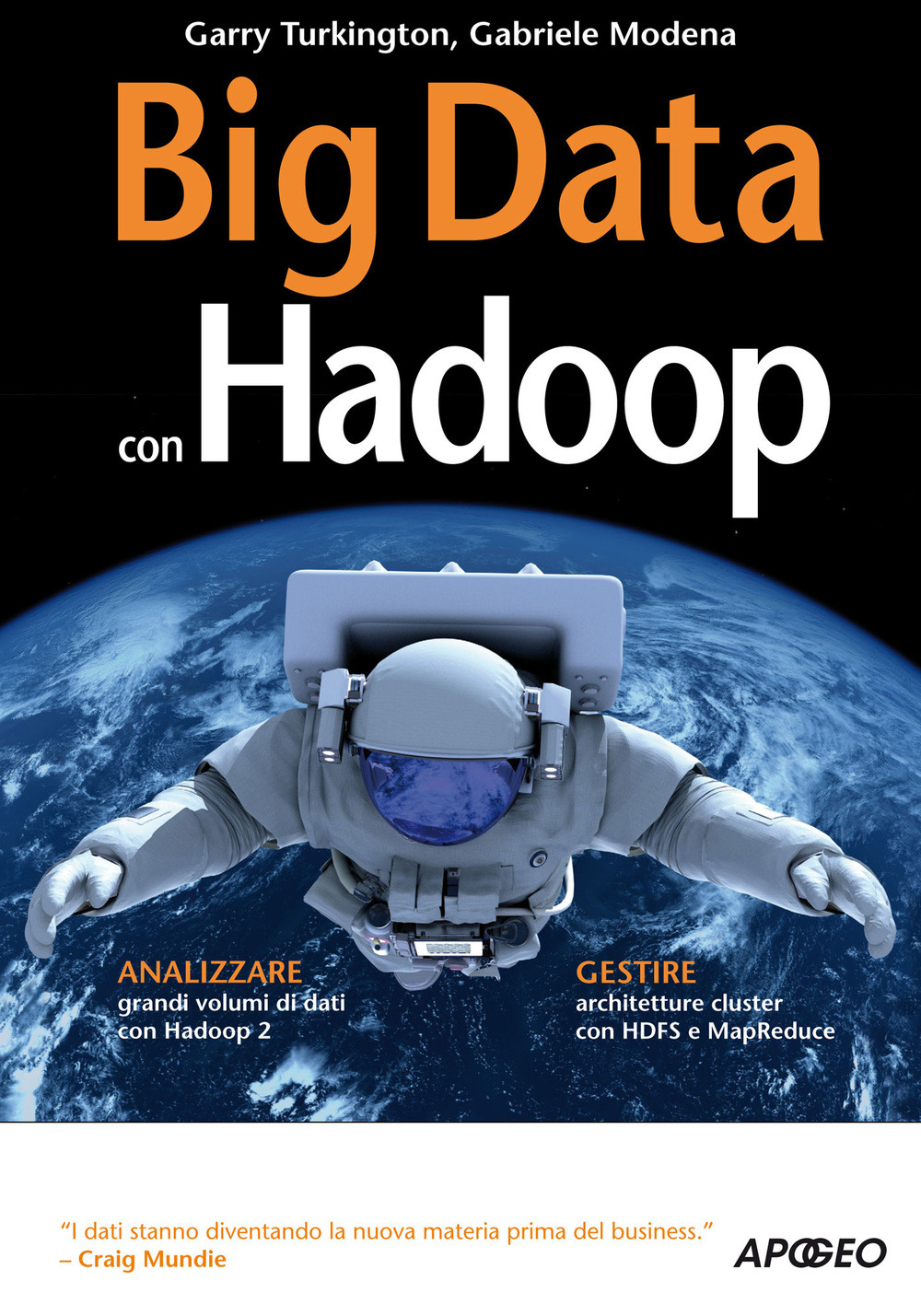

Big Data con Hadoop

Hadoop è un progetto software open source che permette di analizzare enormi quantità di dati distribuiti su cluster di computer e file system differenti. È progettato per essere completamente scalabile da un singolo server fino a migliaia di macchine. Hadoop si occupa anche di gestire problemi e guasti a livello applicativo piuttosto che hardware e questo garantisce migliori e più accurate prestazioni. Hadoop è mantenuto da The Apache Software Foundation e si basa sul linguaggio di programmazione Java. Questo libro è dedicato a chi non conosce Hadoop ma ha la necessità di lavorare e gestire Big Data. L'approccio è sia teorico che pragmatico e tutoriale. Si parte dall'installazione e dalla configurazione di Hadoop, per passare alla progettazione, l'implementazione e la gestione di sistemi complessi attraverso le varie componenti del software tra cui HDFS, YARN e MapReduce. Passo dopo passo il lettore scoprirà i componenti di Hadoop imparando a utilizzarli nella costruzione di soluzioni in grado di ottenere il massimo dai dati collezionati.

-

Autore:

-

Traduttore:

-

Editore:

-

Collana:

-

Anno edizione:2015

Le schede prodotto sono aggiornate in conformità al Regolamento UE 988/2023. Laddove ci fossero taluni dati non disponibili per ragioni indipendenti da Feltrinelli, vi informiamo che stiamo compiendo ogni ragionevole sforzo per inserirli. Vi invitiamo a controllare periodicamente il sito www.lafeltrinelli.it per eventuali novità e aggiornamenti.

Per le vendite di prodotti da terze parti, ciascun venditore si assume la piena e diretta responsabilità per la commercializzazione del prodotto e per la sua conformità al Regolamento UE 988/2023, nonché alle normative nazionali ed europee vigenti.

Per informazioni sulla sicurezza dei prodotti, contattare productsafety@feltrinelli.it